Ich hatte heute ein Gespräch mit Bekannten darüber, ob die fehlende Weiterentwicklung des Militärs in den präkolumbianischen Gesellschaften ein Hinweis darauf sein könnte, dass diese Kulturen weniger gewalttätig und kriegerisch waren als die europäischen, wo sich das Militär ständig weiterentwickelte – aber eben auch permanent extreme Kriege geführt wurden.

Daraufhin wurde mir entgegnet: „Die haben nicht nur ihren Feinden bei lebendigem Leib das Herz herausgeschnitten, sondern sogar ihre Ballspielchampions den Göttern geopfert“ – als Beispiel für ihre Brutalität.

Aber gab es Vergleichbares nicht auch in Europa? Zum Beispiel in England das sogenannte Vierteilen („hanged, drawn and quartered“): Verurteilte wurden zunächst gehängt, dann bei lebendigem Leib ausgeweidet, die Eingeweide verbrannt, der Körper geköpft und schließlich in vier Teile zerschnitten. Ein berühmter Fall ist William Wallace im Jahr 1305. Die Überreste wurden öffentlich zur Abschreckung ausgestellt.

Auch das Rädern, bei dem Menschen an ein Rad gebunden und durch Knochenbrüche getötet wurden, war weit verbreitet – oft dauerte das Sterben stunden- oder tagelang. Verbrennungen auf dem Scheiterhaufen, wie bei „Ketzern“ oder „Hexen“, wurden bis in die Neuzeit zelebriert – mit religiöser Begründung.

Besonders auffällig: Diese Grausamkeiten wurden in Europa bewusst öffentlich inszeniert. Sie waren soziale Spektakel, mit Marktständen, Gaffern, Spott und Jubel. Man ging dorthin wie zu einem Volksfest. Das Volk sollte nicht nur sehen, was passiert – sondern, warum: zur Einschüchterung und Machterhaltung.

Im Unterschied dazu wurden die Opferungen bei den Azteken oder Maya religiös begründet – als Gaben an die Götter, um das Gleichgewicht der Welt zu erhalten. Aus heutiger Sicht nicht weniger grausam, aber mit einem anderen ideologischen Fundament.

Vor diesem Hintergrund lassen sich zwei mögliche Indizien dafür benennen, dass die präkolumbianischen Gesellschaften nicht notwendigerweise gewalttätiger waren als die europäischen – vielleicht sogar weniger:

1. Die fehlende militärische Weiterentwicklung: Anders als in Europa, wo ständig neue Waffentechnologien und Kriegsführungsstrategien entwickelt wurden, blieb das Militär vieler präkolumbianischer Kulturen technologisch vergleichsweise statisch. Das könnte – zumindest teilweise – auf eine geringere strukturelle Ausrichtung auf kriegerische Expansion hindeuten.

2. Die Formen der Gewalt unterscheiden sich, nicht unbedingt deren Ausmaß: Menschenopfer wirken heute besonders fremd und barbarisch, sind aber in ihrer Grausamkeit vergleichbar mit den europäischen Praktiken der Folter und Hinrichtung. Beide Systeme kannten ritualisierte Gewalt, nur unter unterschiedlichen ideologischen Vorzeichen – religiös dort, juristisch oder politisch hier.

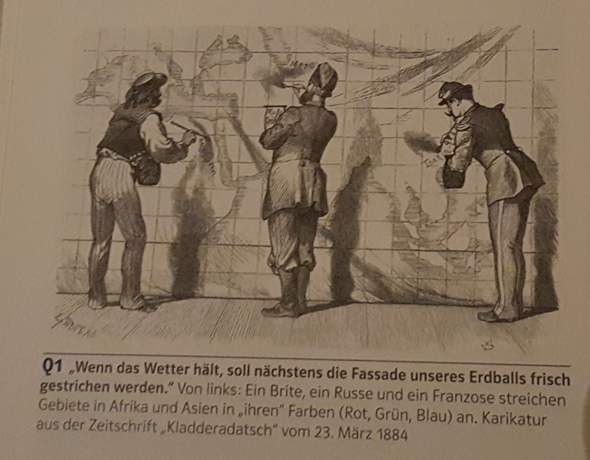

Diese Überlegungen werfen die Frage auf, ob das Bild der besonders gewalttätigen „anderen Kulturen“ nicht auch ein Produkt europäischer Perspektiven und kolonialer Geschichtsschreibung ist müssen wir alle dahingehend offener werden?