Hallo,

ich mache eine Programmierer-Ausbildung bei einer großen öffentlichen Firma und habe dort sehr gute Übernahmechancen nach der Ausbildung.

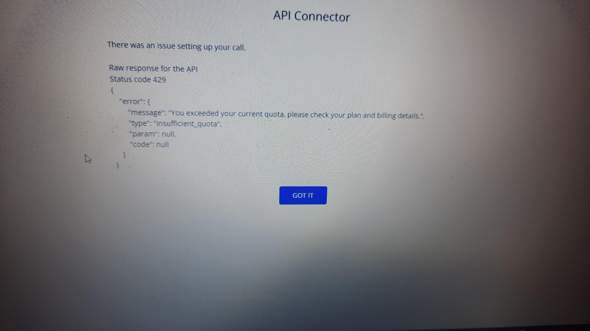

Chatgpt/GPT4 kann meiner Meinung nach schon sehr gut programmieren, debuggen und dokumentieren. Meine Sorge ist jetzt, ob diese KI uns Programmierer in der Zukunft ersetzen könnte. GPT4 hilft mir bisher wenig auf der Arbeit, aber was ist mit besseren Versionen von GPT? Der Sprung von Chatgpt 3.5 zu Gpt4 ist einfach so enorm... Ich frag mich, wie groß der Sprung zu neueren Modellen sein wird.

Weil ich habe momentan extreme Angst, dass meine Ausbildung doch nur Zeitverschwendung ist. Ich würde gern für immer als Software Entwickler arbeiten und hätte echt nicht die Nerven mit Mitte 30 arbeitslos zu werden während ich meine Kinder ernähren muss und ein Haus abbezahle.

Also was ist eure Meinung? Sollte ich vielleicht sogar die Ausbildung abbrechen und zum Beispiel Handwerk machen? Oder hat Software Entwicklung Zukunft wie jeder sagt?

Also kann ich auf diesen Beruf im öffentlichen Dienst setzen, wenn ich in der Zukunft ein Haus abbezahlen will und eine Familie gründen will? Bitte seid ehrlich!