Hi Ich habe mal wieder eine Frage und zwar zu Harry Potter.

Also: Harry stammt ja von der Peverell Familie ab, nämlich von Ignotus Peverell, von dem er auch den Tarnumhang geerbt hat. Harry ist ja auch entfernt mit Voldemort verwandt, ich glaube, über Catmus Peverell.

Ist Harry dann eigentlich auch sehr entfernt und über Umwege mit Salazar Slytherin verwandt, ich meine nicht von der direkten Abstammung her, sondern einfach sehr entfernt?

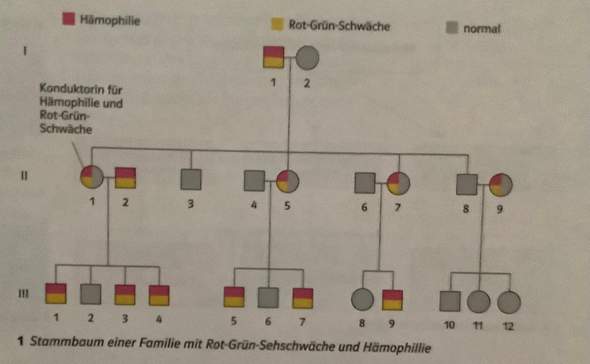

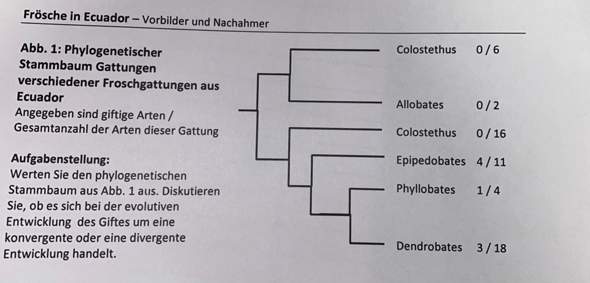

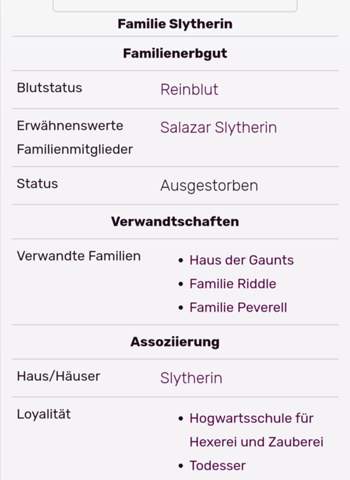

Weil auf harrypotter.fandom.com steht zB. dass die Familie Slytherin mit der Familie Peverell verwandt ist:

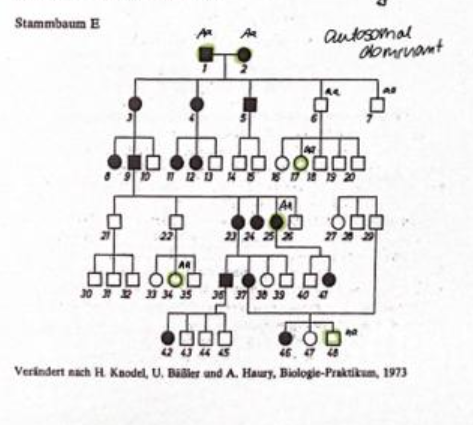

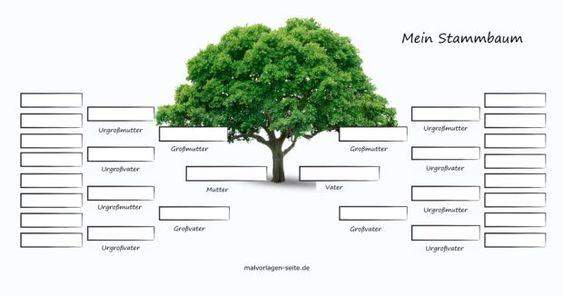

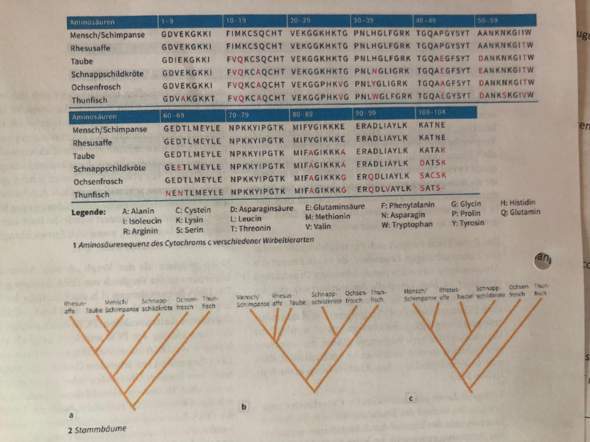

Oder hier steht es auch nochmal im Stammbaum:

Was sagt ihr dazu, sind sie verwandt?

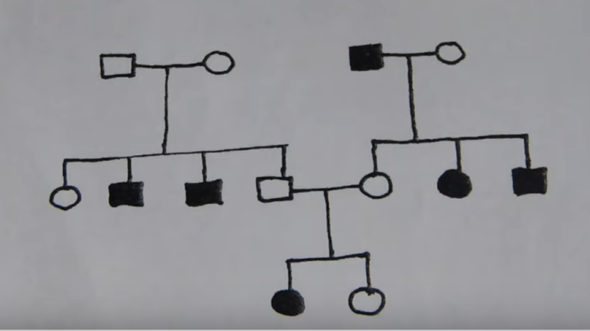

Und ja, ich kenne mich nicht wirklich mit Stammbäume aus, also, wenn ich einen Fehler gemacht habe, dürft ihr mich gerne eines Besseren belehren? :)

Vielen Dank schon mal für die Antworten.