Was wurde aus den europäischen gesetzlosen Menschen am Ende des Wilden Westens?

Anfangs gabs ja noch Aufbruchstimmung.

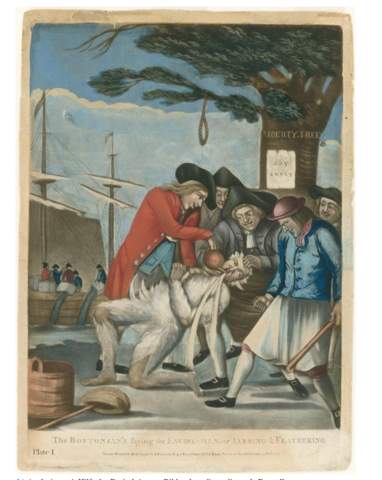

Also Goldrausch, Konflikte mit den Ureinwohnern, den Westen weiter für sich beanspruchen. Also mir gehts eher um die Gesetzeslosen.

Das wird immer glorifiziert, dass man dort noch frei und wild lebte.

Irgendwann um 1787 gründete sich ja der US Staat und annektierte immer mehr Gebiete. Ich weiß um viele Verbrechen der Staaten an den Ureinwohnern, Verträge die gebrochen wurden aus kapitalistischen und rassistischen Gründen. Und kennt ihr gute Dokus, die neutral sind?