Was wäre die beste Sprache um Daten so schnell wie möglich von Websites zu scrapen?

Klar gibt es da viele Möglichkeiten und sowas geht auch easy in Python, aber sagen wir es gibt 1.000 Websites wo das Script daten von Scrapen soll und lokal abspeichern soll und das so schnell wie möglich, welche Sprache wäre am besten? C oder?

3 Antworten

Die beste Sprache zum schnellen Scrapen von Daten hängt von den Anforderungen des Projekts ab, aber Python ist eine der populärsten und effektivsten Sprachen dafür. Es bietet zahlreiche Bibliotheken wie **BeautifulSoup**, **Scrapy** und **Selenium**, die das Web Scraping erheblich erleichtern. Python ist relativ einfach zu lernen, flexibel und hat eine große Community, die bei Problemen unterstützt.

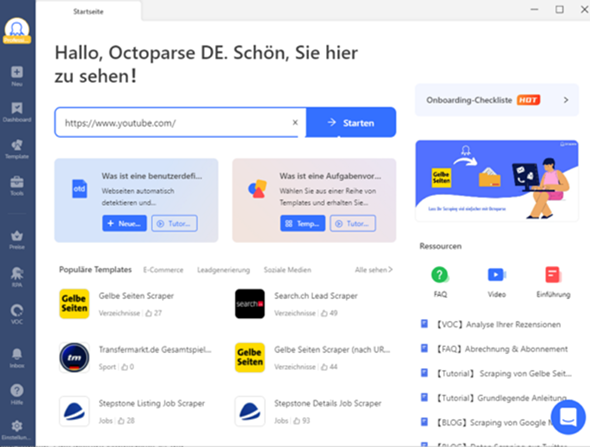

Allerdings, wenn Sie nicht programmieren möchten oder das Scraping besonders schnell und ohne Code erledigen wollen, ist **Octoparse** eine hervorragende Alternative. Es handelt sich um ein No-Coding Web Scraping Tool, das Benutzern erlaubt, große Mengen an Daten von Websites zu extrahieren, ohne dass Programmierkenntnisse erforderlich sind. Octoparse automatisiert den gesamten Prozess und spart so erheblich Zeit.

Mit Octoparse können Sie sofort loslegen, ohne die Zeit in das Erlernen einer Programmiersprache investieren zu müssen, was es zur besten Option für schnelle und unkomplizierte Web Scraping-Aufgaben macht.

C kann sicherlich sehr schnell sein, aber es ist eine niedrigere Programmiersprache und eignet sich nicht gut für Web-Scraping-Aufgaben. Python ist eine gute Wahl für Web-Scraping, weil es eine sehr leistungsstarke Sprache mit einer Vielzahl von Bibliotheken wie BeautifulSoup und Scrapy ist, die speziell für Web-Scraping entwickelt wurden.

wenn du auf Geschwindigkeit und Effizienz achtst und mit Python vertraut bist, ist es wahrscheinlich die bessere Wahl

Die Frage ist nicht was die beste Sprache ist, sondern was die beste Library ist. Und für Python gibt es ziemlich gute wie z.B. BeautifulSoup.

Aber auch für JavaScript/Node gibt es seht gute Optionen wie Cheerio.

Wenn du extrem viele Seiten schnell scrapen willst, kann es sein, dass JavaScript eine bessere Performance bietet, da es besser für asynchrone Aufgaben optimiert ist.

1000 Webseiten ist allerdings nicht viel. Da ist es egal was du verwendest. Viel wären 1000 Seiten pro Sekunde, aber ich glaub nicht dass du das vor hast.