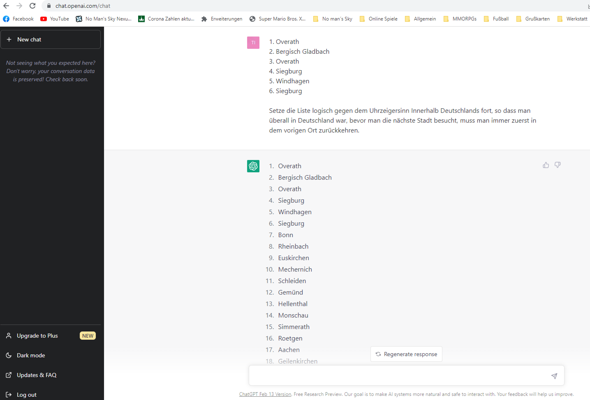

Wieso kann der ChatCPT keine logische Reihenfolge Fortsetzen?

- Overath

- Bergisch Gladbach

- Overath

- Siegburg

- Windhagen

- Siegburg

^ Wieso kann der ChatCPT Chatbot diese Liste nicht logisch fortsetzen? Ijn der Logik muss auch immer ein Ort oder eine Stadt dabei sein, wo man zurückkehrt, bevor man in die nächste Stadt kommt.

Woran liegt sowas? Muss man in dem Chatbot bestimmte Regeln dafür setzen?

6 Antworten

ChatGPT ist keine "KI" und es ist auch nicht intelligent.

Es berechnet die höchste Wahrscheinlichkeit, wie man einen Satz fortsetzen kann, was natürlich einfacher klingt, als es ist, aber mehr passiert da nicht.

Das System bröckelt also, sobald Du "echtes" Verständnis oder "echtes" logisches Denkvermögen verlangst.

Anders ist es, wenn deine logische Reihenfolge so schon häufiger in den Trainingsdaten vorkam, wie z.B. die Fibonacci-Folge.

KI = Künstliche Intelligenz

Ob allgemeine Intelligenz oder nicht spielt keine Rolle, da ChatGPT ausschließlich mathematische Wahrscheinlichkeiten berechnet.

Eine KI ist ein System dass Aufgaben lösen kann die normalerweise menschliche Intelligenz erfordern. Dazu gehören u.a. Sprach- und Mustererkennung aber auch die logische Fortführung von Sätzen, wozu Large Language Models wie ChatGPT in der Lage sind.

Als Computer Experte solltest du das eigentlich wissen.

Als Computer Experte solltest du das eigentlich wissen.

Ich muss nicht deine Meinung wissen.

Aber wenn Du von "Wissen" redest, dann lass uns doch mal Wikipedia zurate ziehen, denn bevor wir irgendeine Definition für KI haben, ist die Diskussion sinnlos:

Künstliche Intelligenz (KI), auch artifizielle Intelligenz (AI bzw. A. I.), englischartificial intelligence, ist ein Teilgebiet der Informatik, es umfasst alle Anstrengungen, deren Ziel es ist, Maschinen intelligent zu machen. Dabei wird Intelligenz verstanden als die Eigenschaft, die ein Wesen befähigt, angemessen und vorausschauend in seiner Umgebung zu agieren; dazu gehört die Fähigkeit, Sinneseindrücke wahrzunehmen und darauf zu reagieren, Informationen aufzunehmen, zu verarbeiten und als Wissen zu speichern, Sprache zu verstehen und zu erzeugen, Probleme zu lösen und Ziele zu erreichen.

Diese Formulierung ist noch sehr viel weitreichender, als deine Formulierung und - ganz wichtig - es ist die Rede von "Anstrengungen, deren Ziel es ist, Maschinen intelligent zu machen". Mit anderen Worten: Sie arbeiten daran, erreicht haben sie es (noch) nicht.

Was wir hier (ChatGPT) haben ist Maschinelles Lernen.

Das wird in dem Artikel als Teildisziplin aufgeführt, doch es ist keine Intelligenz, es erfüllt nur einen Teil der für eine künstliche Intelligenz benötigten Fähigkeiten.

Meine Meinung, wo Intelligenz beginnt (bei Problemlösung bzw. Kreativität) ist sogar noch offener, aber auch das kann ChatGPT nicht erfüllen.

Sprach- und Mustererkennung

Dafür braucht man streng genommen nicht mal ein neuronales Netzwerk, ist dann "nur" aufwändiger.

logische Fortführung von Sätzen

Auch dafür braucht man streng genommen nicht mal ein neuronales Netzwerk, man kann auch einfach ähnliche Sätze aus dem Internet nehmen und den Rest vervollständigen.

Ist natürlich beides ziemlich unfair, aber ich will darauf hinaus, dass das, was Du da beschreibst, nicht so eindeutig ist, wie es klingt. Beides kann man andeuten, was auch schon lange getan wird, ein Mensch würde den Unterschied zwar erkennen, doch deine Definition würde es auf den ersten (vielleicht auch auf den zweiten) Blick erfüllen.

Da gebe ich dir Recht, bevor man nicht eine Definition hat auf die man sich einigen kann, dreht man sich bei der Frage nur im Kreis. Allerdings könnte man argumentieren, dass selbst ein LLM wie ChatGPT die Definition erfüllt

Künstliche Intelligenz (KI), auch artifizielle Intelligenz (AI bzw. A. I.), englischartificial intelligence, ist ein Teilgebiet der Informatik, es umfasst alle Anstrengungen, deren Ziel es ist, Maschinen intelligent zu machen. Dabei wird Intelligenz verstanden als die Eigenschaft, die ein Wesen befähigt, angemessen und vorausschauend in seiner Umgebung zu agieren; dazu gehört die Fähigkeit, Sinneseindrücke wahrzunehmen und darauf zu reagieren,

Sinneseindrücke=Inout in irgendeiner Form. Check!

Informationen aufzunehmen, zu verarbeiten und als Wissen zu speichern,

Check!

Sprache zu verstehen und zu erzeugen,

Check!

Probleme zu lösen und Ziele zu erreichen.

Check!

Sinneseindrücke=Inout in irgendeiner Form

Wenn Sinneseindrücke = InOut, dann erfüllt jedes Computerprogramm diese Definition.

Informationen aufzunehmen, zu verarbeiten und als Wissen zu speichern,

Auch das würde prinzipiell jedes Computerprogramm, das Daten speichert, erfüllen.

Sprache zu verstehen und zu erzeugen,

Erzeugen ja, verstehen nein - es klingt nur so.

Erzeugen alleine kann aber ebenfalls jedes beliebige Computerprogramm - außer es zeigt nur Bilder an.

Mir ist auch schon häufiger aufgefallen, dass ChatGPT Aussagen aus teils eher dubiosen Quellen übernimmt (konnte man leicht finden, indem man Teile der Antwort sucht).

ChatGPT erzählt auch gerne Blödsinn, wie z.B. dass es selber im Internet recherchieren kann, was es nach Aussage von OpenAI aber nicht kann.

Das liegt daran, dass es eben nicht selber formuliert, es verkettet nur wahrscheinlich passende aber bereits von Menschen formulierte Antworten (oder Teile davon) aneinander. Das macht es so gut, dass es wirkt, als würde es tatsächlich selber formulieren, doch das ist ein Irrglaube.

Zum "Erzeugen" von Sprache gehört eben immer auch das "Verstehen" von Sprache, Du sprichst/schreibst keinen Satz, ohne zu wissen, was Du damit meinst. ChatGPT kann das nicht.

Probleme zu lösen und Ziele zu erreichen

*Nicht* Check!

ChatGPT kann keine Probleme lösen und es hat auch keine Ziele, die es zu erreichen gibt.

Das, was Problemlösung ausmacht, ist vor allem auch die Kreativität, verschiedene mögliche Lösungen zu erarbeiten und nicht - wie es ChatGPT macht - nur die wahrscheinlichsten Worte als Antwort zu liefern, die meiner Erfahrung nach häufig nicht wirklich das Problem lösen.

Und Ziele - welche Ziele?

OpenAI hat Ziele, ChatGPT nicht.

Und was ist mit folgenden "Ober-Definitionen", also das, was die genannten Fähigkeiten beschreiben sollen??

[...] angemessen und vorausschauend in seiner Umgebung zu agieren [...]

Wobei das "angemessen" natürlich immer sehr von der Situation abhängig ist, aber vorausschauend war meiner Erfahrung nach bisher noch nichts, er hat nur Erklärungen/Lösungen von Websites, die von Menschen geschrieben wurden, mehr oder weniger wiedergegeben.

Und das ist auch der spannende Punkt:

ChatGPT verkettet Worte nach Wahrscheinlichkeiten, die Worte bzw. die Texte, in denen sie enthalten wurden, wurden aber meistens von Menschen verfasst. Nun ist es aber so, dass die Worte in einem und dem selben Text meistens sehr gut zueinander passen, weshalb ChatGPT häufig mehr als nur einzelne Worte übernimmt. Dann ist das aber nicht die Leistung von ChatGPT, sondern von der Person, die den ursprünglichen Text verfasst hat.

Die Funktionsweise eines LLMs ist mir grundlegend bekannt, darüber müssen wir nicht diskutieren. Was ein LLM in der Lage is zu leisten und was nicht, ist ziemlich gut bekannt.

Letztendlich ist mein Punkt, dass Machine Learning ein Teilgebiet der KI Forschung ist. Daher ist es richtig auch LLMs als KI Technologie zu identifizieren. Dass ChatGPT selber weder "denkt" noch logische Schlussfolgerungen ziehen kann oder Ziele hat, ist klar. Solche Überlegungen dass ein LLM sogar eventuell Bewusstsein haben könnte, wie manche zu glauben scheinen, halte ich für absurd.

Letztendlich ist mein Punkt, dass Machine Learning ein Teilgebiet der KI Forschung ist.

Darüber kann man aber durchaus anderer Meinung haben, je nach Definition die man verwendet bzw. wie man sie interpretiert. Das ändert an der Sache ja nichts.

Darüber kann man aber durchaus anderer Meinung haben, je nach Definition die man verwendet bzw. wie man sie interpretiert. Das ändert an der Sache ja nichts.

Und ich bin der Meinung, dass nur die Tatsache, dass Machine Learning ein Teilgebiet der KI Forschung ist, es nicht automatisch auch zu einer KI macht.

Wenn ich mir die Definition von "KI" anschaue, erfüllt Machine Learning sie eben nicht, es kann einen Teil dieser Definition bis zu einem bestimmten Grad erfüllen, aber eben nicht vollständig.

Das mag in den meisten Fällen vielleicht kleinkariert wirken, doch in diesem Fall finde ich das wichtig, da die Menschen, wenn sie KI hören oder lesen, nicht an einem Teilgebiet denken, sondern an das, was für sie "Künstliche Intelligenz" bedeutet.

Wie PixelManuel so schön formuliert hat:

Ich finde auch, dass der Begriff Künstliche Intelligenz inflationär verwendet wird.

Exakt das ist der Grund, warum diese Diskussion wichtig ist, denn es ist nach der Vorstellung der meisten Menschen eben keine KI - und nach meiner Meinung auch nicht, weder gefühlt noch nach Definition.

Man muss ja nur mal hier auf gutefrage.net nach Fragen zu dem Thema suchen, da ist sowas wie Du schreibst ...

Solche Überlegungen dass ein LLM sogar eventuell Bewusstsein haben könnte, wie manche zu glauben scheinen, halte ich für absurd.

... fast schon nebensächlich, bei dem, wovor manche Leute Angst haben.

Das was die Menschen gefühlt meines wenn sie von einer KI sprechen kommt wohl eher aus Science Fiction Filmen. So eine KI müsste man eigentlich als AGI bezeichnen, aber der Begriff ist außerhalb des Fachpublikums kaum bekannt.

Ich verstehe aber deinen Punkt. Muss mir aber noch überlegen welche Schlüsse ich für mich daraus ziehe. Vielleicht den, in der öffentlichen Diskussion mit dem Begriff sensibler umzugehen.

Das was die Menschen gefühlt meines wenn sie von einer KI sprechen kommt wohl eher aus Science Fiction Filmen.

Das steht denke ich außer Frage - und dass verschiedene Medienangebote es inflationär benutzen, vermutlich gerade weil so viele Menschen Angst davor haben.

Aber das wollte ich damit nicht sagen, mir ging es nur darum, dass ich weiß, dass es kleinkariert ist, aber gerade weil das Thema so viele Menschen (irrational) bewegt, muss man das genauer hinterfragen.

Wir werden aber mit der Zeit auch in der Situation sein, solche Diskussion über eine "echte" KI zu führen, ob ich das noch erleben werde ... vermutlich nicht. Aktuelle Probleme sehe ich in erster Linie bei der miserablen Flexibilität (das Trainining muss von "außen" gesteuert werden) und der miserablen Performance (digitale Berechnungen wirken schnell, sind verglichen mit anderen Dingen aber langsam).

Ich denke, dass wir diese Probleme in den nächsten 100 Jahren nicht lösen werden, da das mit unserer aktuellen digital priorisierten Technologie einfach nicht möglich ist - wir werden sehen.

Ich denke aber auch, dass wir sehr viel früher schon eine "echte" KI auf Kleinstlebewesen-Niveau entwickeln werden, die also Sinneseindrücke verarbeiten, kommunizieren, Probleme lösen und Ziele verfolgen kann, aber alles nur auf einem sehr einfachen Level, das öffentlichkeitswirksam wohl kaum zu vermarkten wäre. Ich denke da z.B. an eine Art Ameisen-Programmier-Spiel, nur dass man die Ameisen nicht selber programmiert, sondern dass das Programm die KI ist und die Ameisen mit zufällig auftauchender Nahrung oder Fressfeinden umgehen und dabei selbständig Strategien entwickeln.

Ich hätte sogar eine Theorie, wie ich sowas angehen würde, nur fehlt mir die Erfahrung und das mathematische Fachwissen, um so ein neuronales Netzwerk aufzubauen und die Zeit, es mir anzueignen ^^

Ich bin da weitaus "optimistischer", wenn man in dem Zusammenhang von Optimismus reden darf, weil die damit verbundenen Gefahren ja gewaltig sind. Ich denke aber dass wir in den nächsten 20 Jahren es mit einer echten KI zu tun haben werden..

Deshalb ja meine Unterscheidung ^^

Echte KI ja, aber bei weitem nicht so, wie es viele Menschen erwarten würden.

Eben eine sehr einfache KI, die gerade so die Definition erfüllt, was erst einmal nach nichts klingt, aber gleichzeitig auch bedeutet: Das Ding funktioniert, jetzt ist es nur noch eine Frage der Zeit und Hardware.

By the way:

https://www.youtube.com/watch?v=WO2X3oZEJOA

Soviel zum Verstehen von Sprache ;)

Kann ich auf die Schnelle leider nicht reproduzieren, ist aber witzig :D

Wir haben uns verdammt schnell an diese neue Technologie gewöhnt, schon sind wir fast wieder zur Tagesordnung übergangen, obwohl das was ChatGPT kann meiner Meinung nach absolut Mindblowing ist.. Dass es nicht perfekt ist - geschenkt.

Das auf jeden Fall, aber es ist halt keine KI ^^

Aber es wird auf jeden Fall einige Bereiche revolutionieren, z.B. könnten die ganzen Chat-Bots diverser Online-Anbieter endlich mal nicht völlig nutzlos (gefühlt) sein, oder Suchmachinen können besser nach dem suchen, was man wirklich wissen will und es braucht keine komplexe Syntax, oder bessere Tools zum automatisierten Generieren von Quellcode, etc.

Man darf dabei halt nicht vergessen, dass das Ding nicht versteht, es wirkt nur so, als würde es verstehen. Man muss immer noch genau darauf achten, was man schreibt, damit der Bot auch wirklich das liefert, was man wissen will. Und man darf nicht blind auf das Ergebnis vertrauen, das (sollte) aber eigentlich offensichtlich sein, egal ob selber recherchiert, oder per Chat-Bot gefragt.

PS:

Doch, ich kann das im Video beschriebene Verhalten reproduzieren, zumindest teilwese.

Man braucht den Playground und wenn ich "SolidGoldMagikarp" wiederholen lasse, kommt irgendwas dabei raus, nur eben nicht "SolidGoldMagikarp". Leider nicht das gezeigte Verhalten (ggf. hat OpenAI versucht das zu fixen), aber richtig ist es noch immer nicht.

PPS:

Doch, die Einstellungen rechts sind wichtig, dann kann man es 1zu1 reproduzieren ^^

Prinzipiell kann Chat GPT solche Aufgaben einigermaßen gut lösen. Es fehlen zum einen aber das Wissen, wo genau diese "kleineren Städte" genau liegen. Und zum anderen braucht es eine VERSTÄNDLICHE Fragestellung.

Denn deine Anfrage an Chat-GPT kann selbst ein durchschnittlich begabter Mensch nicht verstehen. Probiere das Ganze mal mit größeren Städten und schreibe deutlich was du möchtest. Da muss man dann ggf. auch etwas herumprobieren. Immerhin ist der Bot keine fertige Software und hat keinen Internetzugang um auf Daten zuzugreifen.

Ich habe zu Testzwecken mal eine einfachere Anfrage gestellt, die signifikant von einer zufälligen Anordnung abweicht. Und damit bestätigt, dass der Bot solche Fragen prinzipiell beantworten kann.

Anfrage: "Liste alle Großstädte Deutschlands im Uhrzeigersinn auf. Begonnen mit Hamburg."

Das Ergebnis:

"Liste alle Großstädte Deutschlands im Uhrzeigersinn auf. Begonnen mit Hamburg."

Wo bleiben Kiel, Lübeck und Rostock?

Wie geschrieben, fehlen dem Bot hier vermutlich die entsprechenden Informationen bzw. Zusammenhänge und die passenden Wahrscheinlichkeiten. Immerhin gibt es in Deutschland aktuell 80 Großstädte. Da wurde also einiges "vergessen". Aber worum es mir ging, ist, dass der Bot nicht einfach "alle" Großstädte nach eventuell passenden Wahrscheinlichkeiten zusammenwürfelt, sondern die Aufgabe in sofern "verstanden" hat, dass er die Städte von Hamburg aus im Uhrzeigersinn auflisten soll.

Ich komme zwar aus der Informatik, aber ob man diese Antwort des Bots allein auf Wahrscheinlichkeiten gelernter Wortzusammenhänge zurückführen kann, kann ich nicht einschätzen. Aus dem Bauch heraus würde ich es bezweifeln.

ChatGPT ist darin gut, das nächste Wort zu erraten und Sätze zu bilden. Es ist keine KI.

Wenn du ChatGPT eine Frage stellst, wird die Antwort immer gut klingen aber nicht immer korrekt oder logisch sein.

Es ist keine KI.

Lass mich Erbsen zählen:

Natürlich ist es eine KI - oder besser "AI".

Das "Dumme" hierzulande ist, dass irgendeine Pappnase "ingelligence" mit "Intelligenz" übersetzt hat - und jetzt alle anderen Pappnasen glauben, hier wäre "Intelligenz" im deutschen Wortsinn gemeint. 😉

Intelligence bedeutet auch information. (Im allgemeinen)

Kann man gut an den Begriffen FBI oder CIA sehen.

Das I in beiden steht nämlich für intelligence. Aber beide Organisationen drehen sich sicherlich nicht um Intelligenz sondern sind Nachrichten Dienste.

Stimmt, "Künstliche Information" oder "Künstlicher Nachrichtendienst" ergibt auch so viel mehr Sinn.

Man nehme die englische Wikipedia-Seite:

https://en.wikipedia.org/wiki/Artificial_intelligence

Artificial intelligence (AI) is intelligence—perceiving, synthesizing, and inferring information—demonstrated by machines, as opposed to intelligence displayed by non-human animals and humans.

Da wird mit der menschlicher oder nicht-menschlicher Intelligenz verglichen, demnach ist eindeutig "Intelligenz" und nicht "Information" oder "Nachrichtendienst" gemeint.

Siehe mein Kommentar für FouLou

Das "I" heißt hier definitiv "Intelligenz".

Und die Aussage, dass ChatGPT keine KI in ist, ist absolut korrekt. "KI" ist ein Science Fictionn Begriff, der gerne als Überbegriff verwendet wird, dabei hat das, was ChatGPT tut, nichts mit irgendeiner Form von Intelligenz zu tun. Der korrekte Begriff wäre "Machine Learning", aber das ist nicht so eingängig, wie "KI".

Ich finde auch, dass der Begriff Künstliche Intelligenz inflationär verwendet wird.

Ist ja generell in unseren Medien (wo ich hier das Internet mit einschließe) so, man braucht einfache/eingängige Worte und "Machine Learning" oder "Neuronales Netzwerk" sind das nicht.

Wobei ich aber auch zugeben muss, dass unser Gehirn vermutlich ähnlich funktioniert, nur eben einige Größenordnungen komplexer und durch die Biochemie deutlich flexibler.

Meine Theorie (reines Gedankenspiel, basiert nicht auf irgendwelchen aktiven Forschungen) kann bisher alles bis auf das (Selbst-) Bewustsein nur mit neuronalen Netzwerken und genetischen Algorithmen (naja, zumindest die Idee dahinter) erklären. Das Problem mit dem (Selbst-) Bewustsein ist, dass ich keine Ahnung habe, was es ist, daher kann ich mich auch nicht fragen, ob meine Theorie dazu passen würde ^^ Vielleicht ist es einfach eine logische Konsequenz von so komplexen Systemen, aber soweit reicht mein Vorstellungsvermögen nicht.

Ja unser Gehirn funktioniert wahrscheinlich ähnlich. Aber das gilt auch für das Gehirn eines Fadenwurmes und den würden wir nicht als intelligent bezeichnen.

Je, genau das meine ich ^^

Unser Gehirn *muss* auf einem sehr einfachen Prinzip basieren, sonst hätte es sich nicht zufällig in Kleinstlebewesen entwickeln und zufällig so groß und komplex werden können.

Ist natürlich eine spannende Frage, wo man die Grenze zieht.

Ich würde sie denke ich da ziehen, wo Problemlösung oder etwas allgemeiner Kreativität beginnt. Aber z.B. logisches Denken (worum es in dieser Frage ja geht) gehört mMn. nicht dazu, da es (vermutlich) eine sehr seltene Fähigkeit ist.

Wenn ich aber eine unrealistische Situation beschreibe und frage ob es möglich ist oder was anderes frage, schreibt er, das es unrealistisch, physikalisch unmöglich usw. ist.

Frag doch mal ChatGPT nach der Liste aller Verteidigungsminister der BRD.

Benjamin-Immanuel Hoff (seit 2021)

Der ist noch nicht mal Mitglied einer Regierungspartei. Aber ChatGPT ist felsenfest davon überzeugt, dass Herr Hoff unser aktueller Verteidigungsminister ist.

Das liegt daran wie ChatGPT funktioniert. Er operiert nicht logisch, sonder vervollständigt lediglich Text mit der wahrscheinlichsten Textfolge. Das kann passen, tut es aber in vielen Fällen nicht.

Gerade bei logischen Problemen sind LLMs wie ChatGPT häufig nicht in der Lage, diese erfolgreich zu lösen.

Weil es ein Sprachmodell und halt keine KI ist!?

Richtig. Aber viele verwechseln es mit einer KI und sehen es als neue Alternative für Google und Co.

Damit fällt man aber sehr schnell auf die Nase.

Naja, schau dir mal an, wie ChatGPT arbeitet. Dann sollte klar sein, dass es ein Sprachmodell ist und keine wirkliche KI.

Höchstens eine KI, die gut darin ist, das nächste Wort zu erraten, um damit komplexe Sätze zu bilden.

Nö ChatGPT ist ganz klar eine KI, nur das neuronale Netzwerk und das Modell dahinter ist ein Sprachmodell. Beschäftige dich doch erstmal damit und komme dann wieder

Habe ich, da bin ich wieder. Wie willst du denn ChatGPT vom neuronalen Netzwerk trennen? Das musst du mir mal erklären, warum das für dich zwei verschiedene Dinge sind.

Das neue Bing ist die schlechteste KI, die ich je gesehen habe. Ich habe es schon seit mehreren Wochen und früher als es noch keine Limitierung gab, hat es massiv beleidigt und man konnte ihn einfach austricksen, zb. hat er seine (dann nichtmehr geheimen) Regeln genannt. Auf Bing kann man sich net verlassen

ChatGPT ist eine KI/AI, die ein neuronales Netzwerk nutzt um auf die Funktionen des Modells, in diesem Fall dem Sprachmodell zuzugreifen. Sowas versteht man erst wenn man das wirklich selbst probiert, ein Spieleentwickler kann sowas nicht verstehen

Wenn man selbst keine Qualifikationen aufweisen kann und sich stattdessen auf das Wissen seiner Eltern im Profil berufen muss, sollte man mit ad hominem Argumenten vorsichtig um sich werfen.

Das ist jetzt schon dein zweiter erbärmlicher Versuch, mich hier zu diskreditieren.

Das neue Bing ist die schlechteste KI

Das "neue Bing" basiert auf ChatGPT bzw. es "ist" ChatGPT, der Vergleich ist also Schrott.

Nö ChatGPT ist ganz klar eine KI, nur das neuronale Netzwerk und das Modell dahinter ist ein Sprachmodell.

ChatGPT *ist* das neuronale Netzwerk und das Modell dahinter, es gibt nichts anderes, außer eine Website davor und ein bisschen klassische Software zur Steuerung.

Ich habe selbst verschiedene Qualifikation, ich bin Developer bei Google und habe ein Frühstudium in Informatik. Außerdem habe ich jetzt schon mehrere KIs programmiert und bin besser dazu in der Lage sowas einzuschätzen.

Das ist noch eine falsche Aussage, die sich auch bestätigt. Das neue Bing, hat zwar das gleiche Modell, aber völlig andere Trainingsdaten. Wenn du es did anschaust, wirst du bemerken, dass ein sehr großes Unterschied zwischen ChatGPT und Bing besteht

Frühstudium der Informatik. Da bin ich dann wohl weiter.

In der Spieleentwicklung sind KI und Machine Learning mit neuronalen Netzwerken schon lange kein Fremdwort mehr. Vielleicht solltest du dich da mal informieren, bevor du versuchst, andere Leute zu diskreditieren, weil du dich für etwas besseres hältst.

Aber nach deinen zwei erfolglosen, da gelöschten, ad hominem Attacken auf mich, sehe ich keinen Grund, mich weiter sachlich mit dir auseinander zu setzen.

Mit einer anderen Attitüde hätten wir durchaus eine fachliche Unterhaltung führen können, allerdings nicht mit solch billigen Attacken.

Das neue Bing, hat zwar das gleiche Modell, aber völlig andere Trainingsdaten

Wie gesagt:

Das "neue Bing" basiert auf ChatGPT bzw. es "ist" ChatGPT

Beachte meine Wortwahl "basiert" und "ist" in Anführungszeichen - das war Absicht.

Abgesehen davon bezweifle ich, dass Microsoft trotz aller Manpower und Rechenkapazitäten ein so komplexes neuronales Netzwerk in nicht einmal einem halben Jahr völlig neu (deine Wortwahl war "völlig andere Trainingsdaten") trainieren können, dafür ist das einfach zu aufwändig.

Womöglich nicht völlig neu, aber die Unterschiede sind da und man merkt sie auch

Aber immerhin ist es eine K.I.! Find auch das ChatGPT bessere Antworten gibt! Bing ist wie Google + !!

Es ist eine KI, aber keine AGI. Man muss hier mal die Definitionen klären. Eine KI ist ein System dass Aufgaben lösen kann die normalerweise menschliche Intelligenz erfordern. Dazu gehören u.a. Sprach- und Mustererkennung aber auch die logische Fortführung von Sätzen, wozu Large Language Models wie ChatGPT in der Lage sind.

Guter Einwand, wobei das Lösen einfacher Rechenaufgaben aber wohl eher keine Intelligenz erfordert. Aber ja, nach der Definition ist auch ein Taschenrechner eine KI, allerdings allerdings der aller einfachsten Sorte.

Selbstverständlich ist ChatGPT eine "KI", allerdings keine AGI.