Multimeter Toleranz berechnen?

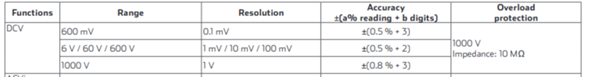

Wie berechne ich die zu erwartende Abweichung eines Multimeters, der Spannung einer gemessenen Spannungsquelle wenn für den Messbereich (bis) 6V eine Genauigkeit von +-0,5% angegeben ist (b digits +2, was auch immer das bedeutet ).

Angenommen ich messe eine fiktive supergenaue niederohmige Spannungsquelle von 1,5V (+-0,000001V). Welche Spannungsschwankungen "von bis" hätte ich mit dem Multimeter zu erwarten?