1080p über DVI nicht möglich?

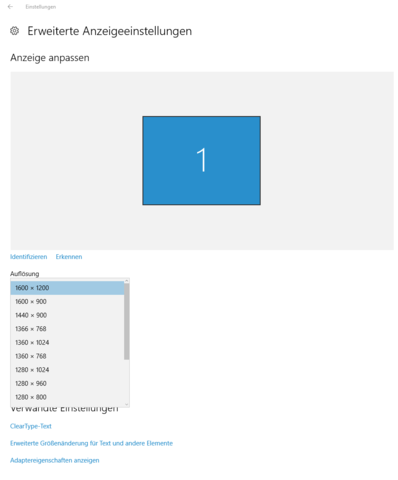

Ich hatte meinen Monitor bisher immer über HDMI mit meiner GraKa verbunden, jetzt wollte ich mein HDMI kabel aber für meinen 2ten Monitor nutzen und meinen 1ten Monitor über ein VGA Kabel mit DVI Adapter an die GraKa anschließen. Nur kann ich jetzt über DVI unter Win 10 unter Anzeigeeinstellungen -> Erweiterte Anzeigeeinstellungen ->Auflösung nicht mehr 1920x1080 auswählen sondern maximal 1600x1200. Eigentlich kann DVI doch 1080p oder nicht?

3 Antworten

DVI-D kann bei Verwendung der vollen 6 Bit pro Clock (über 24-adrige Kabel, sog. "Dual-Link") bis 2560x1600 bei 60 Hz übertragen, bei Verwendung von 3 Bit pro Clock (über 18-adrige Kabel, sog. "Single-Link") bis 1920x1200 bei 60 Hz. In beiden Fällen ist 1080p also kein Problem.

Wenn Du einen DVI-zu-VGA-Adapter verwendest, benutzt Du allerdings nicht DVI-D, sondern DVI-A, das einfach nur ein VGA-Signal über einen DVI-Stecker bereitstellt. Der Adapter ist vollkommen passiv und nimmt keine Signalumwandlung vor.

Verfügt der Monitor über einen DVI(-D)-Eingang? Wenn ja, benutze bitte ein DVI(-D)-Kabel. DVI(-D) lässt sich übrigens auch über passive Adapter problemlos auf HDMI adaptieren, falls Dir das etwas nützt. (Z. B. wenn Du beide Monitore per HDMI anbinden möchtest, Deine Grafikkarte aber nur einen HDMI-Ausgang hat.) HDMI ist nämlich auf elektrischer Ebene identisch zu DVI-D, da beide das selbe Signalisierungsverfahren (TMDS) benutzen. Allerdings ist HDMI grundsätzlich "Single-Link" (3 Bit pro Clock). Über einen DVI-D-zu-HDMI-Adapter bekommst Du somit maximal 1920x1200 bei 60 Hz drüber.

Prinzipiell schon. VGA ist allerdings analog und hat somit keine genaue "Auflösungsbeschränkung". Das Bild wird einfach unschärfer, weil die hohen Frequenzen irgendwann nicht mehr sauber rüber kommen. Die Auflösung, die Deine Grafikkarte wiedergeben kann, hängt von der Geschwindigkeit des verbauten RAMDACs (Digital-Analog-Wandlers) ab.

Da heutzutage kaum noch analoge Monitore verwendet werden, könnte ich mir vorstellen, dass die RAMDACs, allem technischen Fortschritt zum Trotz, bei neueren Grafikkarten sogar immer schlechter werden, einfach um Kosten zu sparen, weil das Feature ohnehin kaum noch jemand nutzt. Ich schätze, dass dort der Hund begraben liegt. Vermutlich macht der RAMDAC bei 1600x1200 und 60 Hz "dicht" oder der Monitor liefert aus irgendeinem Grund fehlerhafte DDC-Daten über VGA.

Okay danke dir für die Antwort und die Erklärung, hat mir sehr geholfen.

Hallo,

DVI ist zu VGA abwärtskompatibel. DVI-I gibt neben dem digitalen DVI-Signal auch das analoge VGA-Signal aus.

Durch deinen Adapter, bzw dein VGA-Kabel kommt auch nur ein analoges VGA-Signal an deinem Monitor an. Das digitale DVI-Signal wird überhaupt nicht übertragen.

Wenn du die Möglichkeit hast, schließ den Monitor doch einfach mit einem DVI-Kabel an dem DVI-Ausgang deiner Grafikkarte an. (Vorsicht es gibt drei unterschiedliche DVI-Stecker. Wikipedia hilft.)

So solltest du auch wieder 1920x1080 einstellen können. 1600x1200 (UXGA) hat bei der analogen Übertragung schwer mit dem Moiré-Effekt zu kämpfen.

https://de.wikipedia.org/wiki/Digital_Visual_Interface#DVI-I

Hi,

vermutlich hast du einen falschen Adapter verwendet.

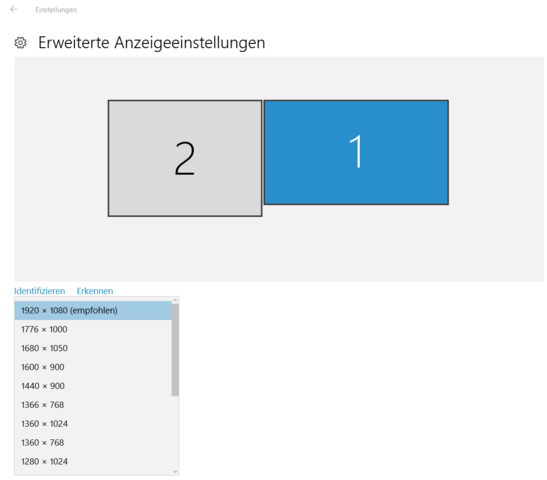

danke du hast mir meinen Fehler aufgezeigt, meine Grafikkarte hat 2 DVI Anschlüsse und einen HDMI, mein Monitor nur HDMI und VGA also hab ich den falschen adapter bzw. nutze ich VGA und kein DVI. Aber lässt sich über VGA nicht auch 1080p nutzen?